專家表示,去年輝達先以H100伺服器晶片領先搶市,今年初在美國開發者大會(GTC)發表用台積電4奈米生產的GB200超級晶片,算力三級跳,讓不少雲端業者放棄自行研發AI伺服器晶片的念頭。話雖如此,在市場需求強烈的狀況下,超微、英特爾並未就此放棄,仍在後面苦苦追趕。

因為如此,黃仁勳此次台北國際電腦展(COMPUTEX)又預告,輝達明年不但會有新版本的AI伺服器晶片,2026年還會推新一代AI晶片架構「Rubin」,會搭配高頻寬記憶體HBM4,並採用台積電3奈米先進製程製造,「這會讓已缺到不行的先進製程與封裝,以及高頻寬記憶體需求,後勢更加看好。」專家直接點出其中關鍵。

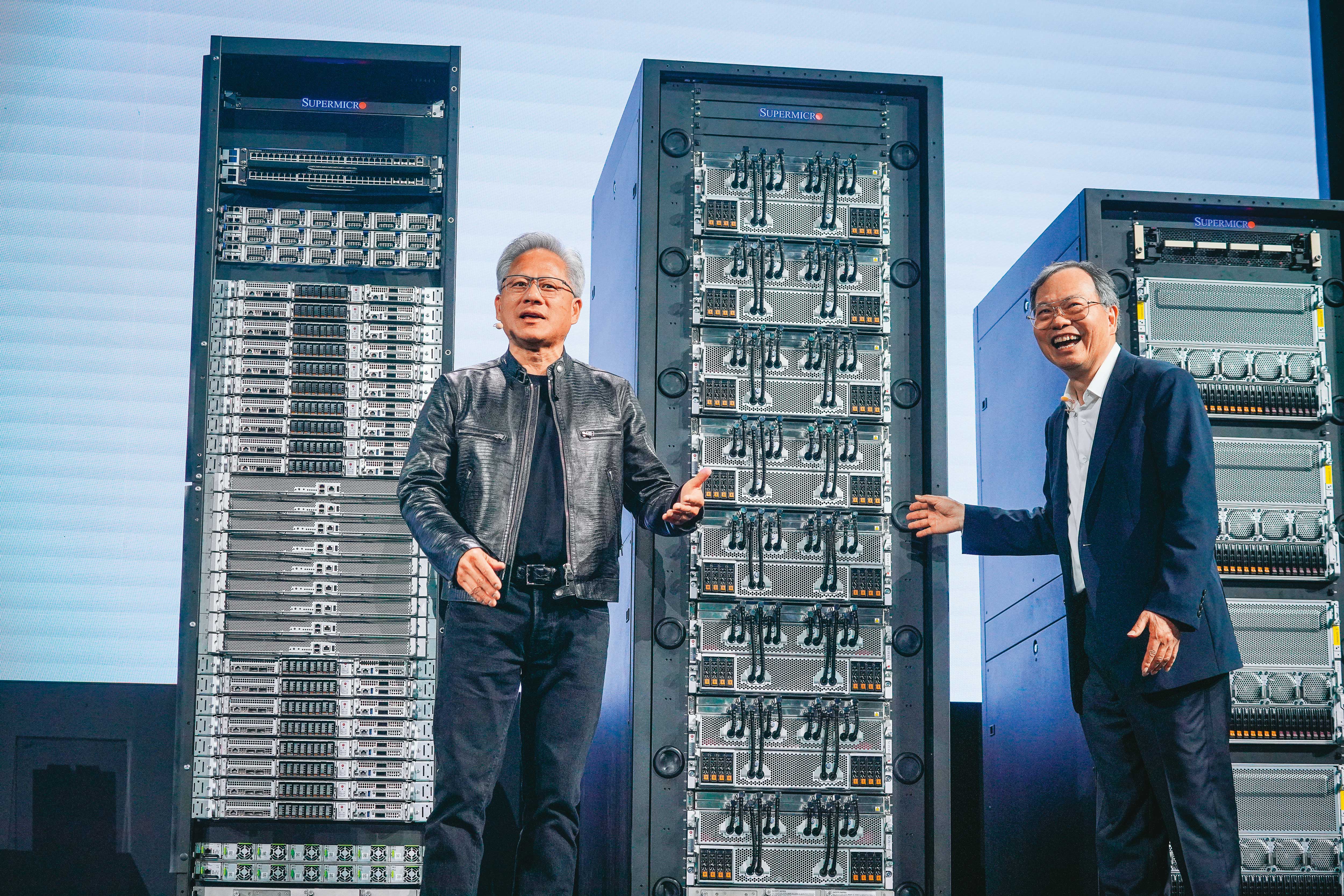

不僅如此,因為高算力引發的散熱問題,黃仁勳特別點名輝達新的DGX GB200 NVL整櫃伺服器將採用水冷散熱技術;該產品也在美超微(Supermicro)創辦人梁見後的主題演講中曝光,受邀站台的黃仁勳用台語稱讚機器:「不但很水,還又酷、又涼。」

一位法人直言,一整櫃AI伺服器動輒3、400萬美元起跳,若為散熱問題讓晶片燒壞,損失慘重;故除AI晶片外,散熱也是未來AI伺服器發展的關鍵之一。「目前能做出機櫃CDU(冷卻液分配裝置),只有資金與技術能力兼備的廠商,如廣達、台達電等,才能獲得雲端服務業者的信賴,率先受益。」

就算輝達在AI伺服器有高達近9成的獨霸市占優勢,但面對超微、英特爾兩大敵手的強力挑戰,黃仁勳除推出效能更好的AI晶片外,另一重大挑戰,就在於伺服器內,GPU間的連接介面、以及乙太網路通訊互通的門檻。為此輝達首創了高速GPU互連技術NVLink,與輝達自行開發的軟體平台CUDA一樣,都是輝達AI帝國的重要護城河。

為挑戰輝達,蘇姿丰和季辛格不約而同在主題演講上,宣傳自家主導的UALink和Ultra Ethernet開放標準協定,強調標準開放才能促進生態系創新。此外,蘇姿丰更拿自家AI晶片與輝達現有產品比較,叫戰意味濃厚。對於兩強叫陣,黃仁勳卻在輝達記者會老神在在地說:「我們的NVLink已經開發到第五代,而UALink只剛起步,等UALink第一代推出,NVLink可能到第七、八代了。」絲毫無懼對手進逼。

AI伺服器需求暴增,連帶也讓BMC(遠端伺服器控制晶片)帶來成長契機。全球最大BMC廠商信驊科技董事長林鴻明對本刊表示,傳統一台伺服器只要一顆BMC,但輝達上一代AI伺服器就用了12顆BMC,隨輝達推出新晶片,對BMC需求也等比提升,現在都要搭配45顆甚至81顆BMC。「因為BMC可模擬伺服器內非常多訊號,並掌控許多控制點,當伺服器運作有什麼風吹草動,第一時間便知道並偵測,可進一步做事後分析,改善伺服器的可信度。也因此,要讓一個伺服器MTBF(平均故障間隔時間)大幅改善,就需要加裝非常多BMC監控整個電腦狀態。」林鴻明進一步解釋。